Lösungen für flüssiggekühlte GPU-Beschleunigung

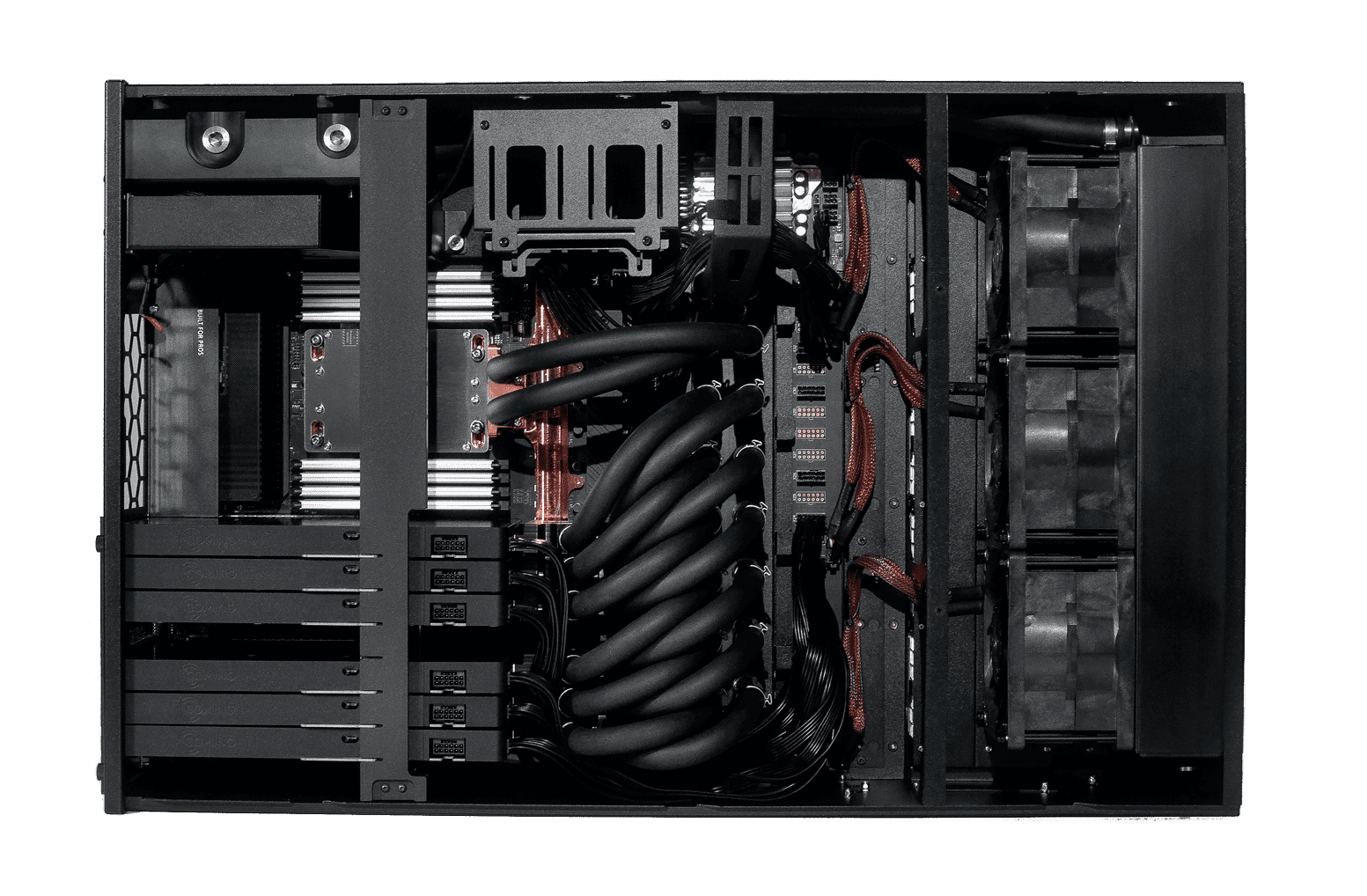

Der Comino Grando AI INFERENCE Server ist eine einzigartige und äußerst kosteneffiziente Lösung, die SECHS flüssigkeitsgekühlte NVIDIA 4090 GPUs mit jeweils 24 GB GDDR6X-Speicher beherbergt, was als Sweet Spot für die meisten Inferenzaufgaben in realen Workloads gilt. Die effiziente Kühlung eliminiert jegliche thermische Drosselung und bietet einen Leistungsvorteil von bis zu 50 % gegenüber ähnlichen luftgekühlten Lösungen. Neben der unübertroffenen Leistung bieten die Comino-Lösungen bis zu 3 Jahre Wartungsfreiheit, eine ebenso einfache Wartung wie bei luftgekühlten Systemen und ein ferngesteuertes Comino Monitoring System (CMS), das über API in Ihren Software-Stack integriert werden kann.

GRANDO

GRANDO

Inference Produktlinie

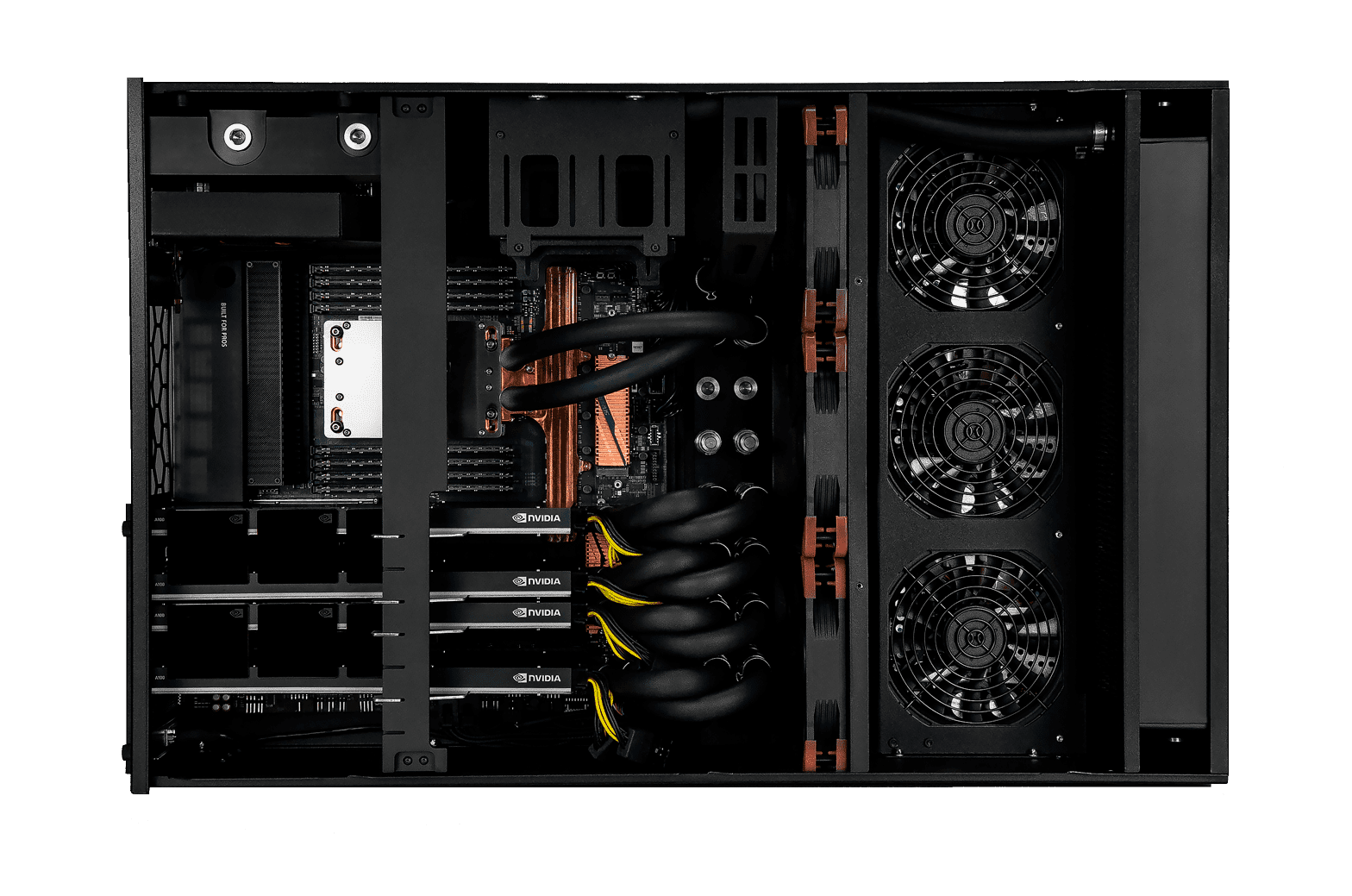

Grando AI INFERENCE Server sind für die Ausführung von cuDNN, PyTorch, TensorFlow, Keras, JAX Frameworks und Bibliotheken vorgetestet und mit SECHS NVIDIA GPUs (A100 / H100 / L40S / 4090) gepaart mit den modernsten Hochfrequenz-Multi-Core-CPUs ausgestattet, um die beste Inferenzleistung und den besten Durchsatz für die anspruchsvollsten und vielseitigsten Workflows zu bieten.

Die Comino Grando AI INFERENCE Server sind für hochleistungsfähige Inferenzen mit geringer Latenz und Feinabstimmung von vortrainierten generativen KI-Modellen für maschinelles Lernen oder Deep Learning wie Stable Diffusion, Midjourney, Hugging Face, Character.AI, QuillBot, DALLE-2 usw. konzipiert. Einzigartige kostenoptimierte und anpassbare Multi-GPU-Konfigurationen sind perfekt für die Skalierung vor Ort oder in einem Rechenzentrum.

AI Inference Server

| Grando AI Inference Base | Grando AI Inference Pro | Grando AI Inference Max | ||

|---|---|---|---|---|

| GPU | 6x NVIDIA RTX4090 | 6X NVIDIA L40S | 6X NVIDIA A100/H100 | |

| GPU Memory | 6x 24GB GDDR6X | 6X 48GB GDDR6 with ECC | 6X 80GB/94GB HBM2e | |

| CPU | AMD THREADRIPPER PRO 7975WX (32 CORES) | AMD THREADRIPPER PRO 7975WX (32 CORES) | AMD THREADRIPPER PRO 7975WX (32 CORES) | |

| System Power Usage | UP TO 3.6 KW | UP TO 3.0 KW | UP TO 3.0 KW | |

| System Memory | 256 GB DDR5 | 512 GB DDR5 | 1024 GB DDR5 | |

| Networking | DUAL-PORT 10GB, 1GB IPMI | DUAL-PORT 10GB, 1GB IPMI | DUAL-PORT 10GB, 1GB IPMI | |

| Storage OS | DUAL 1.92TB M.2 NVME DRIVE | DUAL 1.92TB M.2 NVME DRIVE | DUAL 1.92TB M.2 NVME DRIVE | |

| Storage Data/Cache | ON REQUEST | ON REQUEST | ON REQUEST | |

| Cooling | CPU & GPU LIQUID COOLING | CPU & GPU LIQUID COOLING | CPU & GPU LIQUID COOLING | |

| System Acoustics | HIGH | HIGH | HIGH | |

| Operating Temperature | UP TO 38ºC | UP TO 38ºC | UP TO 38ºC | |

| Software | UBUNTU / WINDOWS | UBUNTU / WINDOWS | UBUNTU / WINDOWS | |

| Size | 439 x 177 x 681 MM | 439 x 177 x 681 MM | 439 x 177 x 681 MM | |

| Class | SERVER | SERVER | SERVER | |

Deep Learning Produktlinie

Comino Grando AI Deep Learning Workstations sind für das Training und die Feinabstimmung komplexer neuronaler Deep Learning-Netzwerke mit großen Datensätzen vor Ort konzipiert und konzentrieren sich auf den Bereich der generativen KI, sind aber nicht darauf beschränkt. Sie bieten erstklassige und einzigartige Multi-GPU-Konfigurationen, um das Training und die Feinabstimmung von rechenintensiven Diffusions-, Multimodal-, Computer Vision-, Large Language (LLM) und anderen Modellen zu beschleunigen.

Die Grando AI DL MAX-Workstation beherbergt VIER flüssigkeitsgekühlte NVIDIA H100-Grafikprozessoren mit 376 GB HBM-Speicher und eine 96-Core Threadripper PRO-CPU, die mit bis zu 5,1 GHz läuft und bis zu 50 % mehr Leistung als vergleichbare luftgekühlte Lösungen bietet. Neben der unübertroffenen Leistung bieten die Comino-Lösungen bis zu 3 Jahre Wartungsfreiheit, eine ebenso einfache Wartung wie bei luftgekühlten Systemen und ein ferngesteuertes Comion Monitoring System (CMS), das über API in Ihren Software-Stack integriert werden kann.

Grando DL Workstations sind vorgetestet, um cuDNN, PyTorch, TensorFlow, Keras, JAX Frameworks und Bibliotheken auszuführen. Sie sind mit VIER NVIDIA GPUs (A100 / H100 / L40S / 4090) gepaart mit den modernsten Hochfrequenz-Multi-Core-CPUs ausgestattet, um eine erstklassige Machine- und Deep-Learning-Leistung in Kombination mit einem geräuscharmen Betrieb selbst für die anspruchsvollsten und vielseitigsten Workflows wie Stable Diffusion, Midjourney, Hugging Face, Character.AI, QuillBot, DALLE-2, etc. zu bieten.

Deep Learning Workstations

| Grando AI Deep Learning Base | Grando AI Deep Learning Pro | Grando AI Deep Learning Max | ||

|---|---|---|---|---|

| GPU | 4x NVIDIA RTX4090 | 4X NVIDIA L40S | 4X NVIDIA A100/H100 | |

| GPU Memory | 4x 24GB GDDR6X | 4X 48GB GDDR6 with ECC | 4X 80GB/94GB HBM2e | |

| CPU | AMD THREADRIPPER PRO 7975WX (32 CORES) | AMD THREADRIPPER PRO 7975WX (32 CORES) | AMD THREADRIPPER PRO 7975WX (32 CORES) | |

| System Power Usage | UP TO 2.6 KW | UP TO 2.2 KW | UP TO 2.2 KW | |

| System Memory | 256 GB DDR5 | 512 GB DDR5 | 1024 GB DDR5 | |

| Networking | DUAL-PORT 10GB, 1GB IPMI | DUAL-PORT 10GB, 1GB IPMI | DUAL-PORT 10GB, 1GB IPMI | |

| Storage OS | DUAL 1.92TB M.2 NVME DRIVE | DUAL 1.92TB M.2 NVME DRIVE | DUAL 1.92TB M.2 NVME DRIVE | |

| Storage Data/Cache | ON REQUEST | ON REQUEST | ON REQUEST | |

| Cooling | CPU & GPU LIQUID COOLING | CPU & GPU LIQUID COOLING | CPU & GPU LIQUID COOLING | |

| System Acoustics | Medium | LOW | LOW | |

| Operating Temperature | UP TO 30ºC | UP TO 30ºC | UP TO 30ºC | |

| Software | UBUNTU / WINDOWS | UBUNTU / WINDOWS | UBUNTU / WINDOWS | |

| Size | 439 x 177 x 681 MM | 439 x 177 x 681 MM | 439 x 177 x 681 MM | |

| Class | WORKSTATION | WORKSTATION | WORKSTATION | |

Features

Flüssigkeitsgekühlt

Flüssigkeitsgekühlt

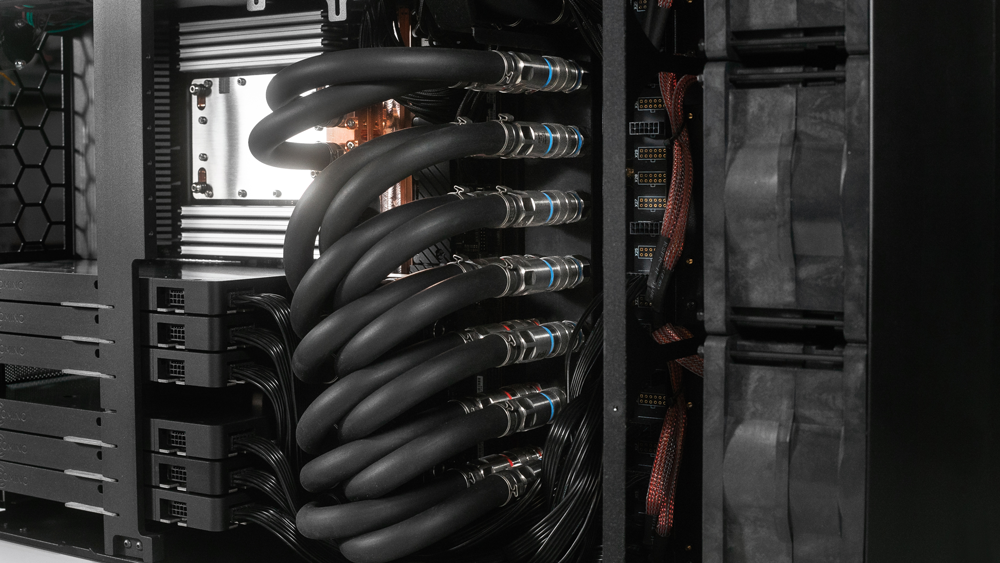

Das Comino-Flüssigkeitskühlsystem setzt das volle Leistungspotenzial moderner Spitzen-GPUs und -CPUs frei, verlängert die Lebensdauer der Hardware und gewährleistet einen 24/7-Betrieb auch in rauen Umgebungen ohne thermische Drosselung.

QUICK-DISCONNECT Kupplungen

Wartung und Reduzierung der Wartungszeit zur Erhöhung der Systemverfügbarkeit.

REMOTE MANAGMENT

BMC-Chip zur Bereitstellung von Intelligenz für seine IPMI-Architektur für Out-of-Band-Management zur Verbesserung der Kontrolle auf Hardware-Ebene für eine verbesserte IT-Effizienz.

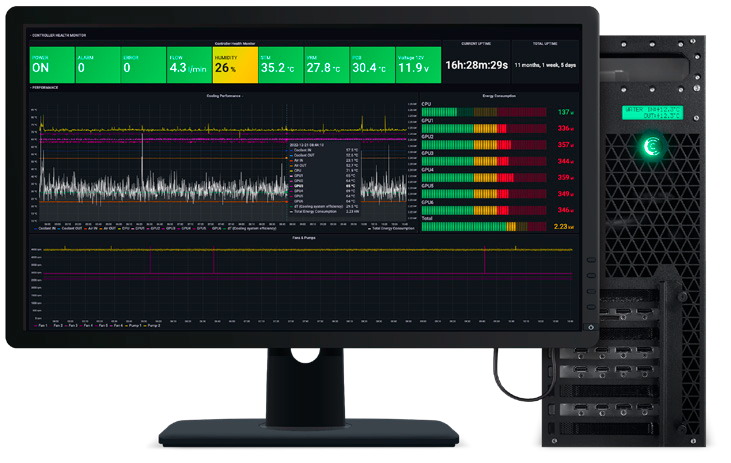

COMINO’S MONITORING SYSTEM

Ermöglicht das Sammeln von Log-Statistiken des Kühlsystems. Die WEB-basierte GUI ermöglicht die Fernüberwachung mehrerer Geräte. Das Überwachungssystem erhöht die Systemverfügbarkeit.

REDUNDANTE NETZTEILE (CRPS)

Entwickelt für den Einsatz in kritischen IT-Infrastrukturen. Es liefert zuverlässige Energie für Ihr System ohne Einschränkungen. Das Netzteil arbeitet mit dem gesamten Spannungsspektrum 100-240VAC und 240VDC und bietet N+M-Redundanz

Maßgeschneiderte Konfigurationen für Ihren Bedarf

Wir konfigurieren Comino Server und Workstation entsprechend Ihrem spezifischen Anwendungsfall. Ein Beispiel für die Konfiguration von Comino-Servern und -Workstations finden Sie oben.

Für weitere Informationen kontaktieren Sie bitte das Zstor Sales Team per E-Mail: